ClickHouse Cloud

この機能は ClickHouse Cloud のプライベートプレビュー段階にあります。所属組織で優先的なアクセスを希望される場合は、 ウェイトリストに登録してください。

ClickHouse Cloud を初めて利用する場合は、 こちら をクリックして詳細を確認するか、無料トライアルにサインアップして使い始めてください。

このオプションは、ClickHouse Cloud を使用している場合を想定して設計されています。このデプロイメントパターンでは、ClickHouse と HyperDX の両方が ClickHouse Cloud 上にホストされるため、ユーザーがセルフホストする必要のあるコンポーネント数を最小限に抑えられます。

インフラストラクチャ管理の負荷を軽減できるだけでなく、このデプロイメントパターンでは認証が ClickHouse Cloud の SSO/SAML と統合されます。セルフホスト型のデプロイメントと異なり、ダッシュボード、保存済み検索、ユーザー設定、アラートといったアプリケーション状態を保存するための MongoDB インスタンスを用意する必要もありません。

このモードでは、データのインジェストは完全にユーザーに委ねられます。ユーザー自身でホストする OpenTelemetry collector、クライアントライブラリからの直接インジェスト、Kafka や S3 などの ClickHouse ネイティブのテーブルエンジン、ETL パイプライン、あるいは ClickHouse Cloud のマネージドインジェストサービスである ClickPipes を使用して、ClickHouse Cloud にデータを取り込むことができます。このアプローチは、ClickStack を最もシンプルかつ高いパフォーマンスで運用するための方法を提供します。

適しているケース

このデプロイメントパターンが最適なのは、次のようなシナリオです。

- すでに ClickHouse Cloud 上にオブザーバビリティデータがあり、それを HyperDX を使って可視化したい場合。

- 大規模なオブザーバビリティのデプロイメントを運用しており、ClickHouse Cloud と組み合わせた ClickStack による専用のパフォーマンスとスケーラビリティが必要な場合。

- すでに分析用途で ClickHouse Cloud を利用しており、同じクラスターにデータを送信する ClickStack のインスツルメンテーションライブラリを使ってアプリケーションを計測したい場合。このケースでは、オブザーバビリティワークロード向けのコンピュートを分離するために warehouses の利用を推奨します。

デプロイメント手順

このガイドは、すでに ClickHouse Cloud サービスを作成済みであることを前提としています。まだサービスを作成していない場合は、クイックスタートガイドの「"Create a ClickHouse service"」の手順に従ってください。

サービス認証情報をコピーする(オプション)

既にサービスで可視化したいオブザーバビリティイベントが存在する場合、この手順はスキップできます。

メインのサービス一覧に移動し、HyperDXで可視化するためにオブザーバビリティイベントを収集するサービスを選択します。

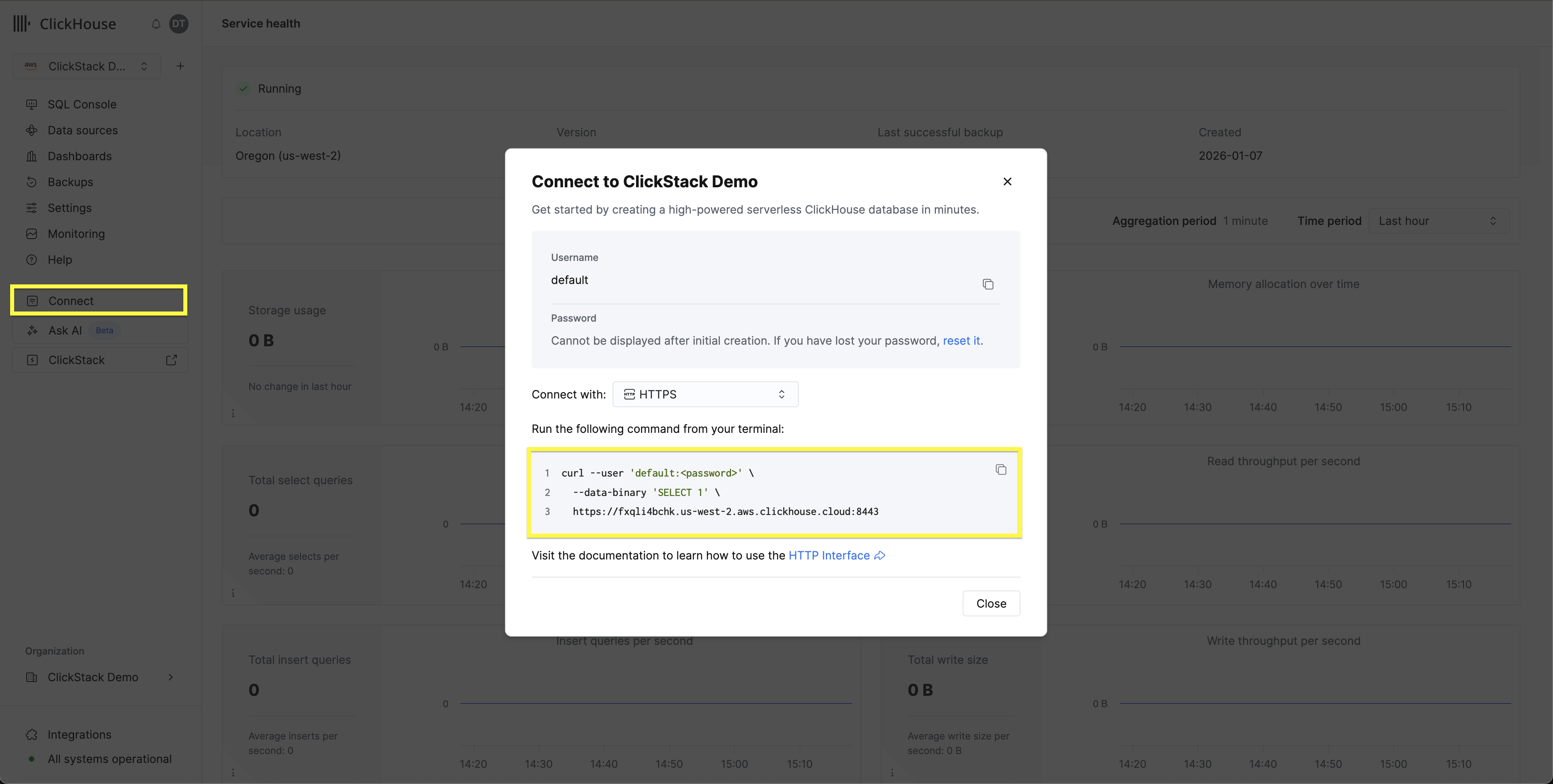

ナビゲーションメニューからConnectボタンをクリックします。モーダルが開き、サービスの認証情報と、各種インターフェースおよび言語での接続手順が表示されます。ドロップダウンからHTTPSを選択し、接続エンドポイントと認証情報を記録します。

OpenTelemetry Collectorのデプロイ(任意)

既にサービスで可視化したいオブザーバビリティイベントが存在する場合、この手順はスキップできます。

このステップにより、OpenTelemetry(OTel)スキーマでテーブルが作成され、HyperDXでデータソースをシームレスに作成できるようになります。また、サンプルデータセットの読み込みやOTelイベントのClickStackへの送信に使用できるOTLPエンドポイントも提供されます。

以下の手順では、ClickStackディストリビューションではなく、OTel collectorの標準ディストリビューションを使用します。後者の場合、設定にOpAMPサーバーが必要ですが、現在プライベートプレビューではサポートされていません。以下の設定は、ClickStackディストリビューションのcollectorで使用されているバージョンを再現し、イベントを送信可能なOTLPエンドポイントを提供します。

OTel collectorの設定ファイルをダウンロードします:

otel-cloud-config.yaml

以下のDockerコマンドを使用してコレクターをデプロイします。環境変数には先ほど記録した接続設定を指定し、オペレーティングシステムに応じて適切なコマンドを使用してください。

本番環境では、インジェスト専用のユーザーを作成し、必要なデータベースとテーブルへのアクセス権限を制限することを推奨します。詳細については、"データベースとインジェストユーザー"を参照してください。

ClickStackに接続する

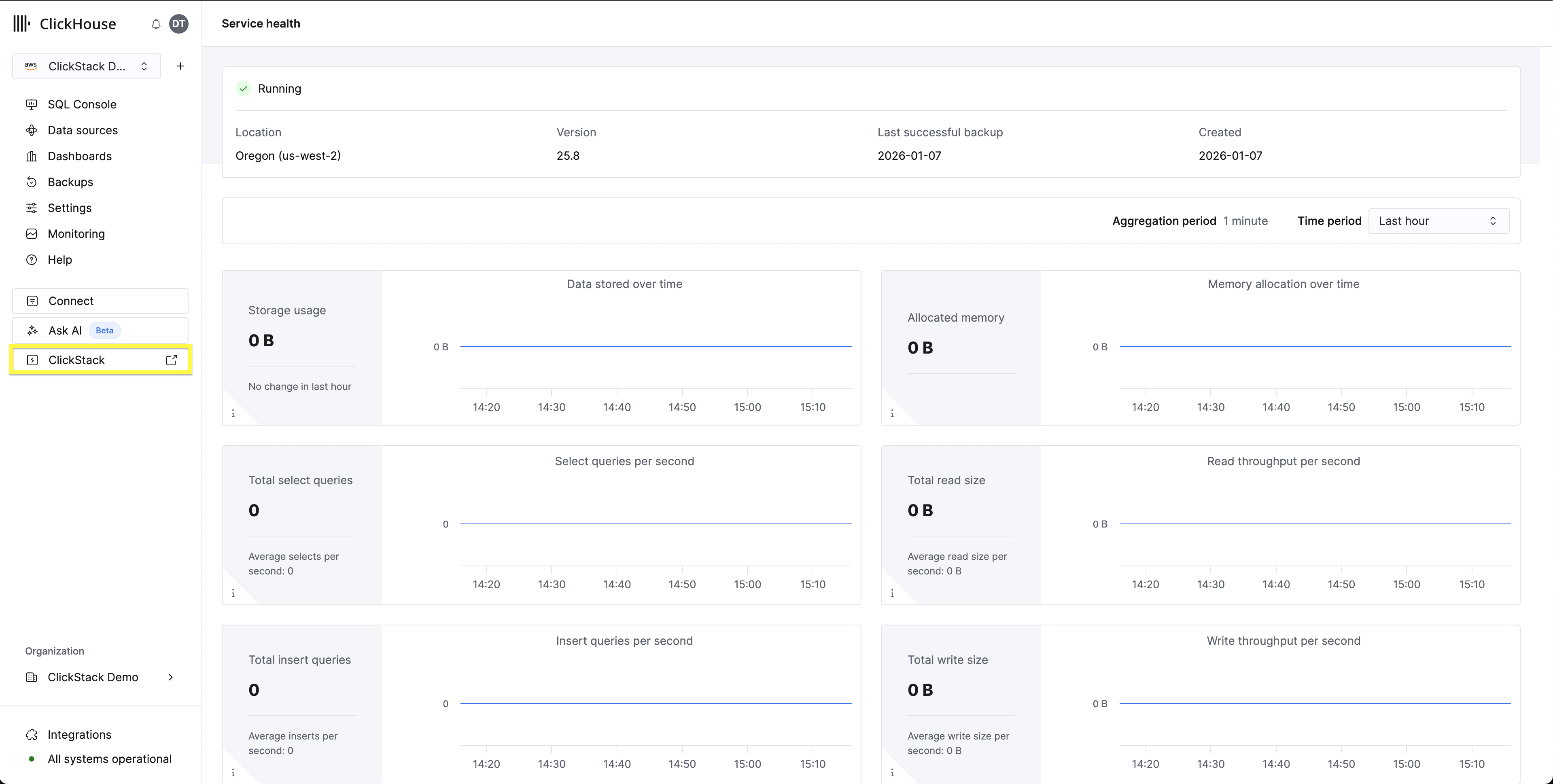

サービスを選択し、左側のメニューから ClickStack を選択します。

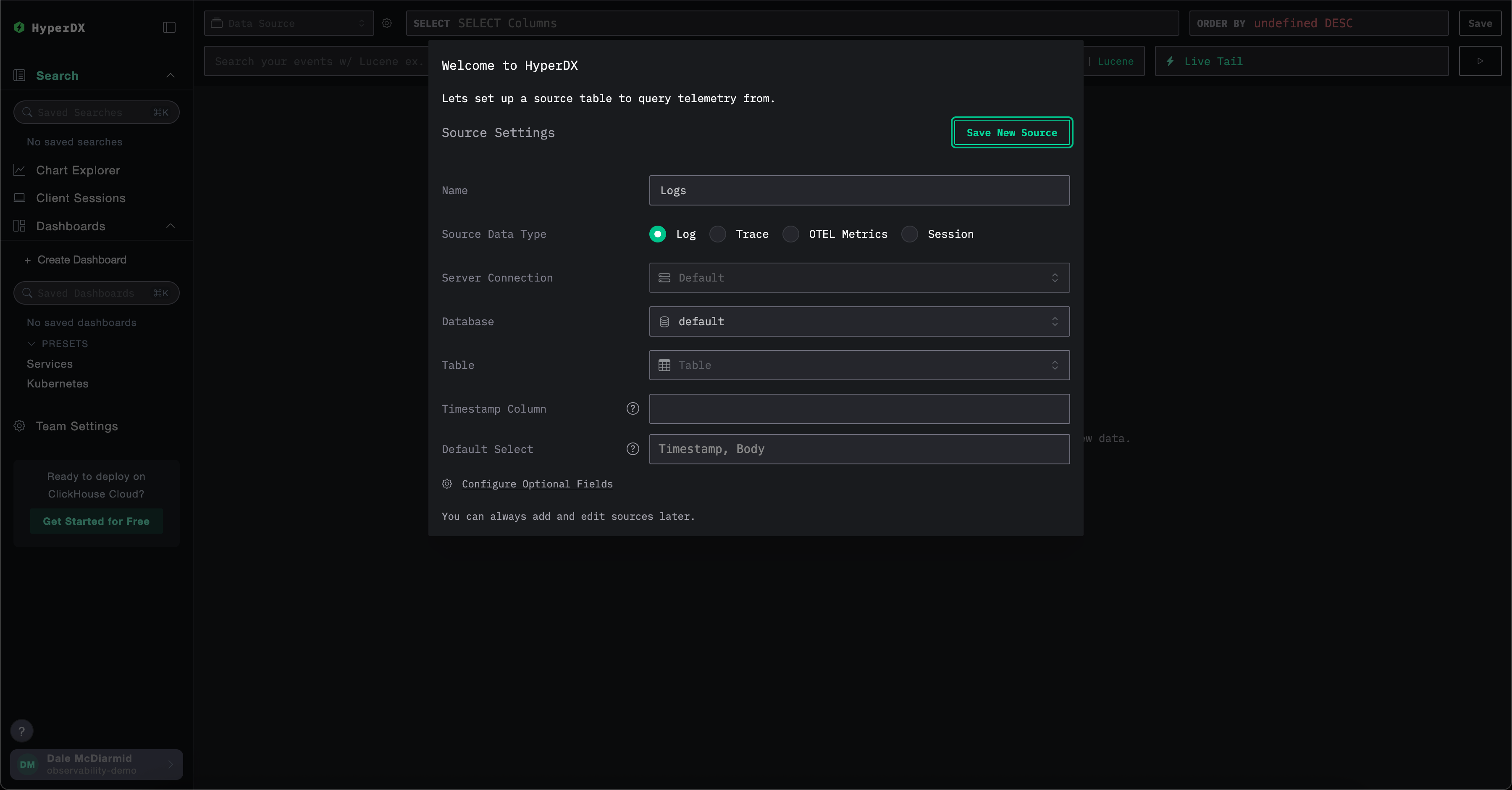

ユーザーを作成する必要はありません。自動的に認証された後、データソースの作成を求められます。

HyperDXインターフェースのみを試したいユーザーには、OTelデータを使用したサンプルデータセットをお勧めします。

ユーザー権限

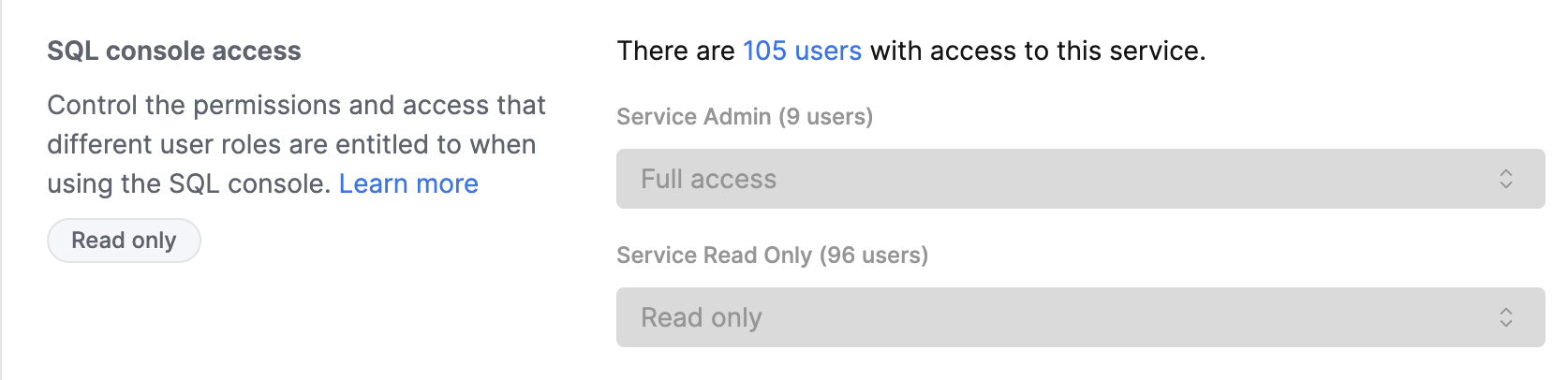

HyperDXにアクセスするユーザーは、ClickHouse Cloudコンソールの認証情報を使用して自動的に認証されます。アクセス制御は、サービス設定で構成されたSQLコンソールの権限によって管理されます。

ユーザーアクセスの設定

- ClickHouse Cloud コンソールでご利用のサービスに移動します

- Settings → SQL Console Access に移動します。

- 各ユーザーごとに適切な権限レベルを設定します。

- Service Admin → Full Access - アラートを有効にするために必要です

- Service Read Only → Read Only - オブザーバビリティデータを表示し、ダッシュボードを作成できます

- No access - HyperDX にアクセスできません

アラートを有効にするには、Service Admin権限(SQLコンソールアクセスのドロップダウンでFull Accessにマッピング)を持つユーザーが少なくとも1名、HyperDXに一度ログインする必要があります。これにより、アラートクエリを実行する専用ユーザーがデータベースにプロビジョニングされます。

データソースの作成

HyperDXはOpenTelemetryネイティブですが、OpenTelemetry専用ではありません。必要に応じて独自のテーブルスキーマを使用することもできます。

OpenTelemetryスキーマの使用

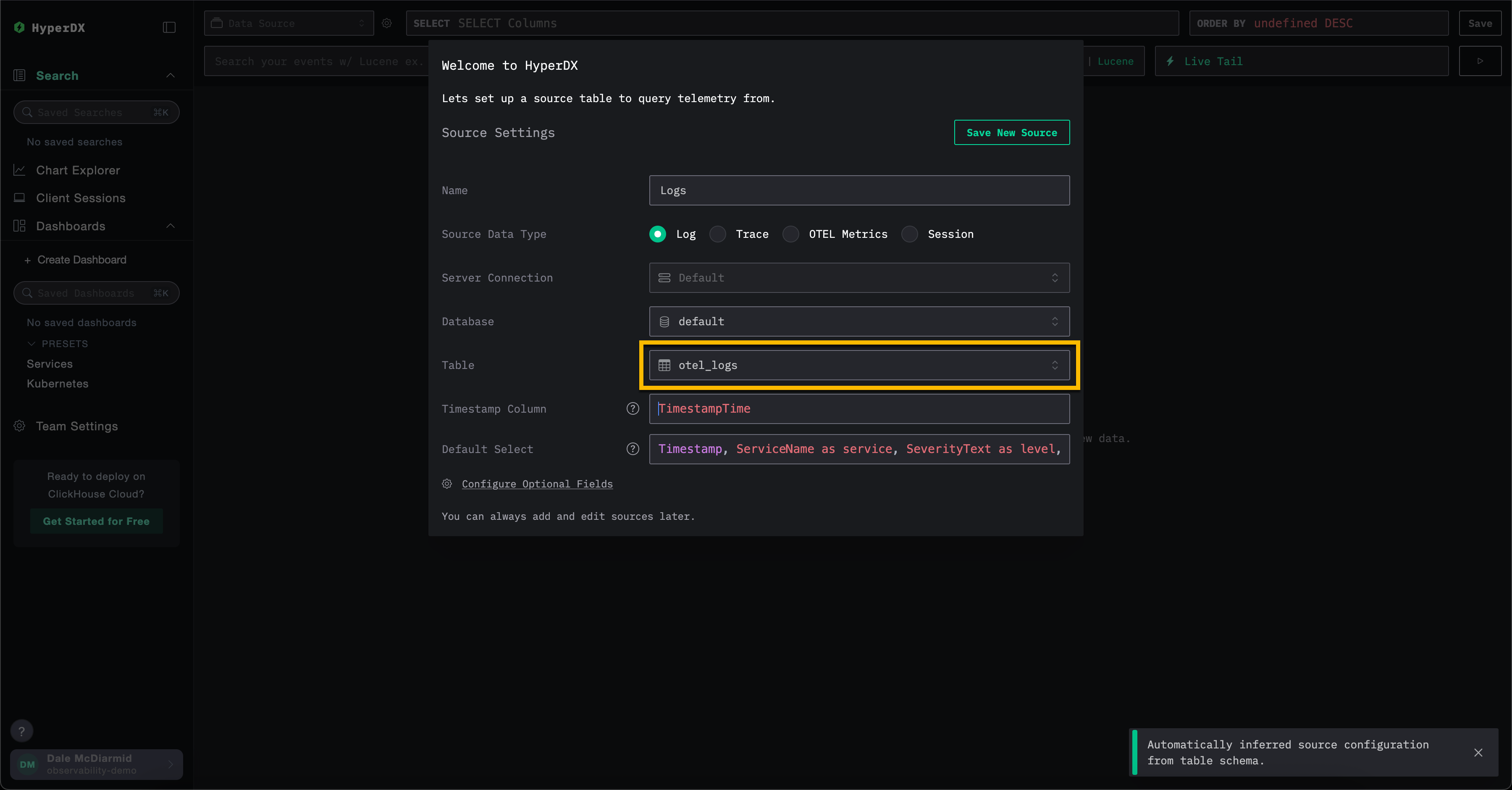

上記のOTel collectorを使用してClickHouse内にデータベースとテーブルを作成する場合、ソース作成モデル内のすべてのデフォルト値を保持し、Tableフィールドに値otel_logsを入力してログソースを作成します。その他の設定はすべて自動検出されるため、Save New Sourceをクリックしてください。

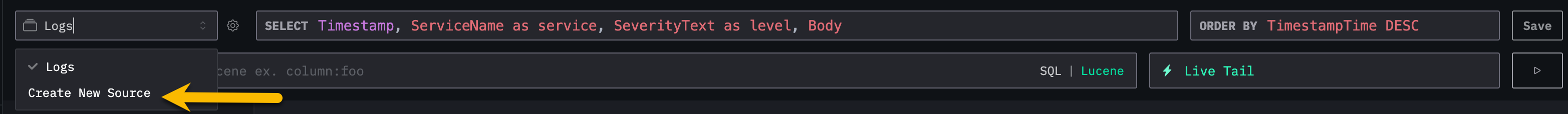

トレースとOTelメトリクスのソースを作成するには、トップメニューから新しいソースを作成を選択してください。

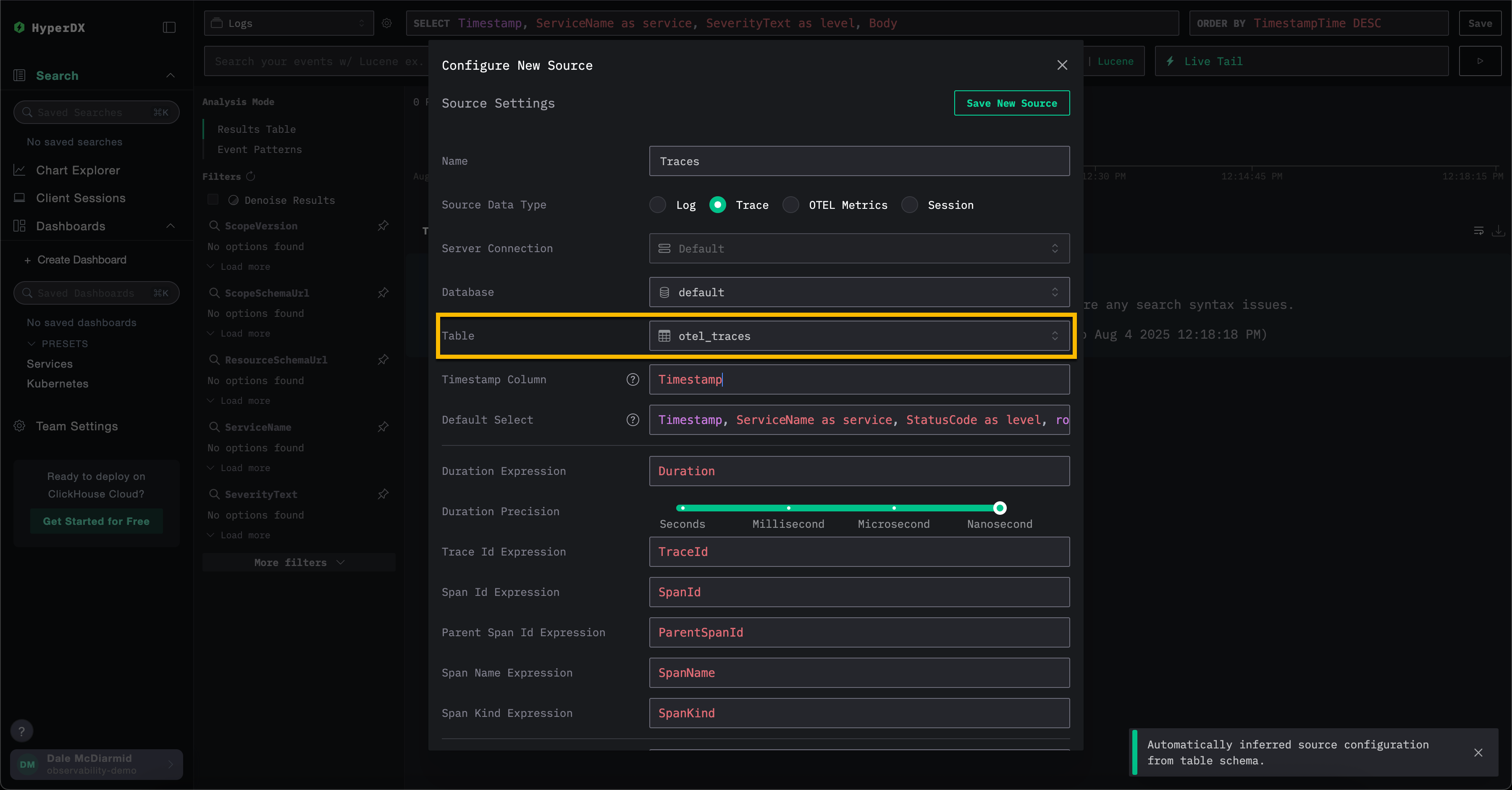

ここから、必要なソースタイプを選択し、続いて適切なテーブルを選択します。例えば、トレースの場合は otel_traces テーブルを選択します。すべての設定は自動検出されるはずです。

ClickStackでは、ログやトレースなどの異なるデータソースを相互に相関付けることができます。これを有効にするには、各ソースで追加の設定が必要です。例えば、ログソースでは対応するトレースソースを指定でき、トレースソースでも同様にログソースを指定できます。詳細については、"相関ソース"を参照してください。

カスタムスキーマの使用

データを持つ既存のサービスにHyperDXを接続する場合、必要に応じてデータベースとテーブルの設定を完了してください。テーブルがClickHouse用のOpenTelemetryスキーマに準拠している場合、設定は自動検出されます。

独自のスキーマを使用する場合は、必須フィールドが指定されたLogsソースを作成することを推奨します。詳細については"ログソース設定"を参照してください。

JSON 型サポート

ClickStack における JSON 型サポートは ベータ機能 です。JSON 型自体は ClickHouse 25.3+ では本番環境向けとして利用可能ですが、ClickStack との統合はまだ積極的に開発中であり、制限があったり、将来的に変更されたり、不具合を含む可能性があります。

ClickStack では、バージョン 2.0.4 以降で JSON 型 をベータ機能としてサポートしています。

この型の利点については JSON 型の利点 を参照してください。

JSON 型のサポートを有効にするには、以下の環境変数を設定する必要があります。

OTEL_AGENT_FEATURE_GATE_ARG='--feature-gates=clickhouse.json'- OTel collector でのサポートを有効にし、スキーマが JSON 型を使用して作成されるようにします。BETA_CH_OTEL_JSON_SCHEMA_ENABLED=true- HyperDX アプリケーションでのサポートを有効にし、JSON データに対してクエリを実行できるようにします。

あわせて、ClickHouse Cloud サービスで JSON が有効化されていることを確認するため、[email protected] へお問い合わせください。